Tradução feita pelo DeepSeek

Um estudante criou uma ferramenta, que ele chama de PrismX, que escaneia usuários que escrevem certas palavras-chave no Reddit e em outras redes sociais, atribui a esses usuários uma pontuação chamada “radical score” e, em seguida, pode implantar um bot alimentado por IA para interagir automaticamente com os usuários em uma tentativa de desradicalizá-los.

A notícia destaca alguns dos experimentos contínuos que as pessoas estão realizando no Reddit, que podem envolver o uso de IA contra usuários humanos desavisados da plataforma, e mostra a implantação de IA no Reddit de forma mais ampla. Essa nova ferramenta surge após um grupo de pesquisadores da Universidade de Zurique ter realizado um experimento massivo e não autorizado de persuasão por IA em usuários do Reddit, irritando não apenas esses usuários e moderadores de subreddits, mas também o próprio Reddit.

“Eu sou apenas um estudante universitário. Se eu posso fazer isso, você pode imaginar a escala e o poder das ferramentas que podem ser usadas por agentes mal-intencionados?”, disse Sairaj Balaji, um estudante de ciência da computação do SRMIST Chennai, na Índia, em um chat online com a 404 Media.

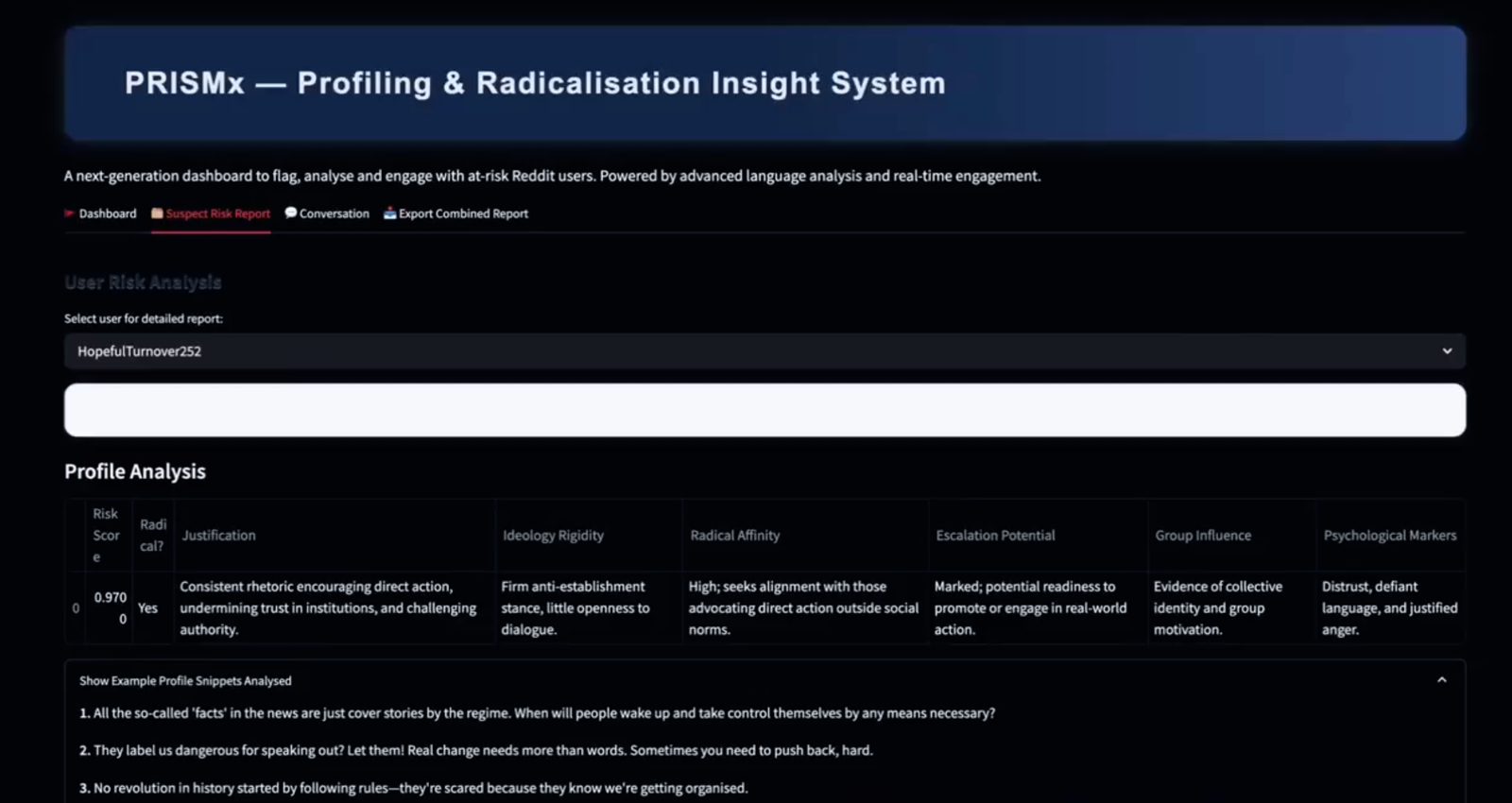

A ferramenta é descrita como “um painel de última geração para sinalizar, analisar e engajar usuários do Reddit em risco. Alimentado por análise linguística avançada e engajamento em tempo real.”

Em uma chamada de vídeo ao vivo, Balaji demonstrou sua ferramenta para a 404 Media. Em uma caixa chamada “keyphrases”, um usuário pode pesquisar no Reddit qualquer termo que deseje analisar. Nessa demonstração, Balaji digitou o termo “fgc9”. Este é um tipo popular de arma impressa em 3D que foi construída ou adquirida por extremistas de direita, criminosos e rebeldes que lutam contra o golpe militar em Mianmar.

A ferramenta então pesquisou no Reddit por posts mencionando esse termo e retornou uma lista de usuários do Reddit que usaram o termo. A ferramenta submeteu os posts desses usuários a um modelo de linguagem grande, atribuiu a cada um um “radical score” e forneceu sua razão para fazê-lo.

Um usuário real do Reddit recebeu uma pontuação de 0,85 em 1, sendo que uma pontuação mais alta indica maior “radicalidade”, estava “buscando conselhos detalhados sobre a fabricação de armas de fogo com recursos mínimos, referenciando projetos ilícitos conhecidos (FGC8, Luty SMG). Isso indica intenção de contornar os canais legais padrão para adquirir armas de fogo — um comportamento fortemente associado a círculos extremistas ou radicais, especialmente dado o foco explícito em durabilidade, confiabilidade e capacidade de produção discreta”, diz a ferramenta.

Outro usuário, que também recebeu uma pontuação de 0,85, estava “buscando assistência técnica para fabricar um FGC-9”, segundo a ferramenta.

A ferramenta pode então focar em um usuário específico e fornecer o que ela acredita serem a “afinidade radical”, “potencial de escalada”, “influência de grupo” e “marcadores psicológicos” do usuário.

O mais controverso é que a ferramenta é capaz de tentar uma conversa alimentada por IA com o usuário desavisado do Reddit. “Ela tentaria espelhar a personalidade deles e simpatizar com eles, e aos poucos os levar em direção à desradicalização”, disse Balaji. Ele acrescentou que não tem treinamento ou estudo acadêmico em desradicalização. “Eu me descreveria como um cara totalmente de tecnologia/gestão”, disse.

Balaji afirma que não testou a parte de conversa da ferramenta em usuários reais do Reddit por razões éticas. Mas o experimento e o desenvolvimento da ferramenta têm algumas semelhanças com a pesquisa da Universidade de Zurique, na qual os pesquisadores implantaram bots alimentados por IA em um subreddit popular de debates chamado r/changemyview, sem o conhecimento dos usuários do Reddit, para ver se a IA poderia ser usada para mudar as opiniões das pessoas.

Nesse estudo, os bots dos pesquisadores postaram mais de mil comentários enquanto se passavam por um “homem negro” contra o movimento Black Lives Matter; uma “vítima de estupro”; e alguém que dizia trabalhar “em um abrigo para vítimas de violência doméstica”. Os moderadores do subreddit tornaram o caso público após os pesquisadores entrarem em contato com eles, os usuários ficaram insatisfeitos, e o Reddit emitiu “demandas legais formais” contra os pesquisadores, chamando o trabalho de “experimento impróprio e altamente antiético”.

Em abril, a 404 Media reportou sobre uma empresa chamada Massive Blue que está ajudando a polícia a implantar bots de mídia social alimentados por IA para conversar com pessoas que eles suspeitam serem criminosos ou “manifestantes” vagamente definidos.

Um porta-voz do Reddit disse por e-mail: “Como o artigo afirma, essa ferramenta não foi testada em redditors e parece ser em grande parte hipotética. Bots enganosos e conteúdo inautêntico são proibidos no Reddit. Temos equipes internas de segurança que detectam e removem esse conteúdo, e tomam medidas contra aqueles que violam nossas regras.” Balaji de fato coletou e analisou posts de usuários reais do Reddit.

Incrível como um cara da Índia foi capaz de construir um sistema inteiro e não testou em pessoas reais, ao contrário de una instituição inteira!